Nous arrivons donc sur ces fameuses « IA » génératrices de texte, comme le désormais célèbre ChatGPT. Et on va commencer par reprendre ce qu'on vient de voir dans le post précédent : bien qu'on nous présente assez souvent une mise en scène où vous entrez un texte pour que l'outil vous « réponde », ce n'est absolument pas ce que l'outil fait en pratique.

La tâche pour laquelle on a entraîné les réseaux de neurones utilisés pour ces outils, en pratique, c'est : prédire le prochain mot d'un texte. C'est tout. Mais en prédisant un mot, puis un autre, puis encore un autre, et en mettant le tout un peu en forme avec une jolie interface de conversation, ça finit par y ressembler assez pour qu'on ait l'impression de dialoguer avec la machine.

Ça n'empêche qu'en pratique, le truc qui fait tourner ChatGPT, c'est seulement une version perfectionnée du mode prédictif pour les SMS que proposent certains téléphones, où vous tapez le début d'une phrase et où vous le laissez compléter, ni plus, ni moins.

En pratique, ces outils reposent sur une technologie appelée LLM, ou « Large Language Model » (« gros modèle de langage » en français), qui est donc un machin entraîné sur un grand nombre de textes et qui a fait plein de règles statistiques dessus, et qui parvient donc, quand on s'en sert pour générer du texte, à faire quelque chose qui ressemble plutôt pas mal (enfin, modulo les soucis qui peuvent venir des données d'entraînement, mais ça, on aura l'occasion d'en reparler dans d'autres posts) à du texte généré par un être humain, d'où le fait que ça nous semble marcher un peu mieux que les quelques tentatives précédentes de faire des « agents conversationnels ».

Parce que oui, si ChatGPT est à la mode depuis seulement quelques années, des agents conversationnels, il y en a eu des tas avant, plus ou moins connus.

On peut par exemple mentionner Tay, un chatbot que Microsoft avait déployé sur le réseau Twitter en 2016… avant de l'en retirer en catastrophe 24h plus tard, parce que leur « IA » s'était déjà mise à débiter du contenu raciste et négationniste.

Pourquoi un tel résultat ? Tout simplement parce que Tay reposait sur un système d'apprentissage comme ceux dont nous avons parlé dans les derniers posts, qui était encore actif : Microsoft mettait à l'époque en avant que « plus vous lui parlez, plus elle devient intelligente » (à comprendre donc comme : vos réponses activent sa répartition de billes interne, elle va ajuster ses probabilités selon ce que vous lui dites), et évidemment une bande de trolls s'étaient alors amusés à lui faire apprendre les pires atrocités possibles. Et j'ai pris cet exemple parce que c'est le premier que j'ai retrouvé en cherchant rapidement

des articles de l'époque, mais il y en a eu quelques autres.

C'est probablement en partie pour cette raison qu'à la sortie de ChatGPT, celui-ci ne savait pas parler d'événements postérieurs à 2021 : OpenAI, la société qui publie cet outil, avait choisi de strictement séparer sa phase d'apprentissage et sa phase d'utilisation. GPT3.5, le moteur qui était utilisé à l'époque, avait été entraîné sur des textes dont les plus récents étaient de 2021, et répondait ensuite sans plus modifier ses probabilités internes.

Mais c'était peut-être aussi en partie parce que l'entraînement d'un LLM, c'est quelque chose qui nécessite beaucoup de texte, et une très grosse puissance de calcul. Ce sont d'ailleurs les deux raisons dont je parlais plus haut pour lesquelles, même si on a vu que l'apprentissage à base de réseaux de neurones était déjà conceptuellement au point dans les années 1980, et que la techno actuelle en est toujours assez proche, l'application n'est arrivée qu'un certain temps après : il fallait d'abord attendre d'avoir accès à une quantité suffisante de texte disponible au format numérique, et que les machines soient assez puissantes pour procéder au traitement. D'ailleurs, qui dit puissance dit aussi consommation : le coût environnemental d'entraînement d'une IA est assez conséquent, on verra si on détaille ce point plus tard ou pas.

En attendant, on peut déjà dire quelques mots sur le coût

humain de ces outils. Parce que dans cette masse de texte qui sert à les entraîner (et qui n'est pas forcément récupérée très légalement, mais pareil, on reparlera peut-être des histoires de droits d'auteur une autre fois), ben il y a aussi une certaine quantité de texte raciste, négationniste, etc. Et qu'OpenAI voulait éviter un fiasco à la Tay.

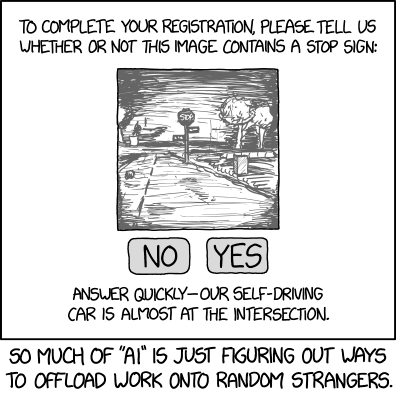

Et donc ils ont décidé de faire en sorte que leur outil soit entraîné non pas une, mais deux fois : d'abord l'entraînement intensif sur un corpus de texte de référence dont on a parlé plus haut pour que leur outil « apprenne à parler » convenablement en ajustant ses probabilités, puis une deuxième phase qu'on appelle un « apprentissage par renforcement », pour lui apprendre à dire certaines choses plutôt que d'autres. Et cette deuxième phase, elle s'obtient en faisant générer à l'outil des tas et des tas de texte, et en les faisant lire à des êtres humains pour qu'ils puissent dire « ça c'était bien, continue comme ça » ou « ça c'était nul, fais autrement ».

Et évidemment, puisque ce sont des boîtes privées capitalistes qui gèrent ce genre de choses, tout a été fait pour minimiser les coûts. Ce renforcement a donc été délocalisé dans les pays pauvres, où la main d'œuvre est moins chère, et pour avoir droit à un gentil ChatGPT qui ne nous insulte pas, il a donc fallu que pas mal de travailleurs sous-payés passent pas mal de temps à lire des textes parfois assez atroces, ce qui n'est pas tip-top pour leur santé mentale.

Soit dit en passant, ce n'est pas le cas seulement pour les « IA génératives », mais également pour pas mal d'autres outils du même style. Si vous utilisez par exemple un assistant vocal, du type Cortana, Alexa ou OK Google, il y a une probabilité non-négligeable pour que vos échanges soient écoutés par une personne chargée de vérifier si la machine a répondu de façon attendue ou pas, je vous renvoie si ça vous intéresse à

ce témoignage par exemple.

Et force est pourtant de constater que, malgré ce second entraînement, ChatGPT et ses collègues continuent de nous sortir régulièrement des absurdités, citant des livres ou des articles qui n'ont jamais été écrits, inventant des faits qui ne se sont pas produits, etc. On a pris l'habitude d'appeler ça des « hallucinations », comme s'il s'agissait d'un dysfonctionnement dans un processus par ailleurs « intelligent ».

Pourtant, si vous avez lu jusque là, vous devez déjà comprendre que cette façon d'appeler ça est trompeuse, et que, comme les surplus de doigts dans les images, ça devient beaucoup plus compréhensible quand on se remet en tête ce que fait vraiment l'outil : il s'agit d'un générateur de texte, entraîné pour mettre des mots à la suite les uns des autres d'une manière à ce que le résultat soit convainquant. Vérifier si ce qu'il dit est vrai ou faux n'est à aucun moment une étape du processus.

En fait, une bonne manière de qualifier ces outils est de les appeler des « générateurs de baratins », attendu que le baratin, c'est précisément ça : un discours produit uniquement pour convaincre, dont la (ou l'absence de) véracité n'entre ou pas en ligne de compte (dans le même genre, certaines personnes appellent aussi ça du « mansplaining as a service »).

Et donc à moins de bien relire et vérifier les informations, ce qui nécessite probablement de déjà bien connaître le sujet sur lequel vous l'interrogez (auquel cas on pourrait se demander si ça ne vaudrait pas mieux de procéder autrement, mais bon), il est préférable de ne pas spécialement leur faire confiance (certains outils se veulent plus fiables que ChatGPT à ce niveau… mais en gardant toujours le même principe de fonctionnement, donc ça reste limité. On aura peut-être l'occasion d'en reparler dans un prochain post).

On peut d'ailleurs se dire que le seul réel apport des LLM et de l'apprentissage machine, par rapport à ce qui se faisait avant, est ce côté

convainquant. On a plus l'impression de tenir une conversation avec quelqu'un face à eux que face aux vieux chatbots qui occupaient déjà les sites de vente en ligne et de réclamation il y a quinze ou vingt ans, qui eux fonctionnaient de manière plus

algorithmique. On avait à l'époque vraiment l'impression de parler à des robots, mais ils arrivaient, en repérant le bon mot clef dans la phrase, à nous proposer tant bien que mal le lien vers la page qu'on cherchait, ce qui était sans doute mieux que d'

inventer.

D'ailleurs, tant qu'à parler des vieux trucs, je ne résiste pas à vous mentionner un peu ELIZA. C'est un logiciel qui n'est pas tout jeune, puisqu'il date du milieu des années 60⁽¹⁾, quelques années seulement après MENACE dont on parlait plus haut. Et il s'agit donc, vous l'aurez deviné, d'un des premiers chatbots. Enfin, un modèle de chatbot un peu particulier, quand même, parce qu'il ne faisait pas dans la conversation courante : il s'agissait d'un outil pour simuler un rendez-vous avec un psy⁽²⁾.

Avec un peu d'astuce, l'informaticien Joseph Weizenbaum avait mis au point un algorithme qui reformulait ce que disait l'utilisateur ou l'utilisatrice pour lui poser des questions à ce sujet et l'inciter à en parler davantage, avec des jokers du genre « je comprends » ou « dites-m'en plus » quand il ne trouvait rien d'exploitable (« ouais, c'est pas faux » n'était pas encore à la mode).

Je ne sais pas combien de personnes ont pu, à l'époque, être convaincues qu'ELIZA comprenait réellement ce qu'on lui disait, mais le fait est que ce genre de choses dépend au moins autant de nous et du contexte que du logiciel qu'on fait réellement tourner (d'ailleurs, vu qu'on est sur un forum sur les jeux vidéos, je pense qu'on pourrait aussi mentionner ici l'assez impressionnant système de discussion avec les extraterrestres proposé dans l'Arche du Captain Blood, un vieux jeu de 1988 que vous avez peut-être déjà vu passer).

Et donc, ça pourrait être une idée qu'on continue ça en parlant un peu de ce que c'est que l'intelligence d'une manière générale, et de la façon dont on la reconnaît, en sortant au passage un peu du domaine informatique pour parler rapidement du monde vivant. Ça nous changera un peu les idées dans le prochain message de la série

(1) Mes vingt ans, tes quarante, si tu crois que cela me tourmente, ah non, vraiment, Lisa ! ♫♪ aurais-je donc pu chanter si j'avais écrit tout ça dans les années qui ont suivi mon arrivée en ces lieux.

(2) Les plus

geeks d'entre vous ont peut-être entendu parler du « psy » intégré au logiciel GNU Emacs. Il s'agit, sauf erreur de ma part, toujours d'un clone d'ELIZA.

Un problème sur votre ordinateur, votre système d'exploitation ou sur Internet ? Des conseils à demander ou à proposer concernant les derniers logiciels disponibles ? Des astuces ou des guides à proposer sur comment nettoyer / optimiser son ordinateur ? Ce forum est le lieu idéal pour parler de nos machines et des programmes autres que les jeux. Débats, sondages, astuces... sans oublier l'annuaire regroupant des liens de sites par thèmes.

Un problème sur votre ordinateur, votre système d'exploitation ou sur Internet ? Des conseils à demander ou à proposer concernant les derniers logiciels disponibles ? Des astuces ou des guides à proposer sur comment nettoyer / optimiser son ordinateur ? Ce forum est le lieu idéal pour parler de nos machines et des programmes autres que les jeux. Débats, sondages, astuces... sans oublier l'annuaire regroupant des liens de sites par thèmes.